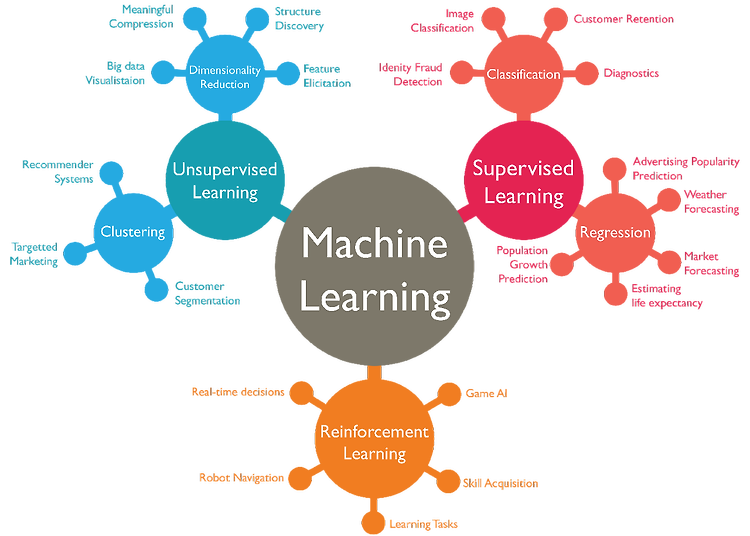

지난 글까지 Regression에 대해 공부했습니다. Regression의 개념과 유형, Regression 모델의 성능을 높이는 데 사용되는 방법, 성능을 측정하는 방식들을 말이죠. 이번 시간부터는 Clustering에 대해 배워볼 예정입니다. [ML101] #1. Machine Learning? 에서 Machine Learning을 크게 Supervised Learning, Unsupervised Learning, Reinforcement Learning 으로 구분할 수 있다는 내용 기억하시나요? 지난 글까지 살펴본 Regression이 Supervised Learning의 대표적인 모델이었다면 오늘부터 살펴볼 Clustering은 Unsupervised Learning의 대표적인 모델입니다. 말 그..